Data science in Industrie 4.0

Big Data, Machine Learning, Product Digital Twins und Predictive Maintenance: Geht es nur darum, Schlagworte zu vermarkten, oder was steckt dahinter? Industrie 4.0 wird immer realer, aber bei weitem noch nicht alle können verstehen, wie es in naher Zukunft aussehen wird. Gleichzeitig ist es für alle Branchen klar, dass dies etwas ist, das wahrscheinlicher wird, wahrscheinlich durch evolutionären Schritte.

Es gibt viele Artikel in fast allen Industriemagazinen über Industrie 4.0 und die Probleme, die es zu lösen gilt, so dass der Leser leicht danach googlen kann. In diesem kleinen Artikel möchten wir unsere Erfahrung und Vision mit Technologien teilen, die zum Verständnis der Thematik beitragen könnten.

Data Science – Was hat das mit Industrie 4.0 zu tun?

Warum sind die Big Data und ihre Analysemethoden für die Umsetzung von Industrie 4.0 so wichtig? Um die Fabrik intelligent und autonom zu machen, muss sie trainiert werden, und deshalb müssen wir mehr und mehr maschinelle Lernmethoden in die Fabrikprozesse einführen. Das Hauptziel des maschinellen Lernens ist die Entwicklung von Algorithmen zur Vorhersage von Daten. Die Algorithmen / Methoden verbessern ihre Leistung adaptiv, wenn die Anzahl der für das Lernen verfügbaren Stichproben zunimmt, und deshalb sind die richtigen Daten hier sehr wichtig.

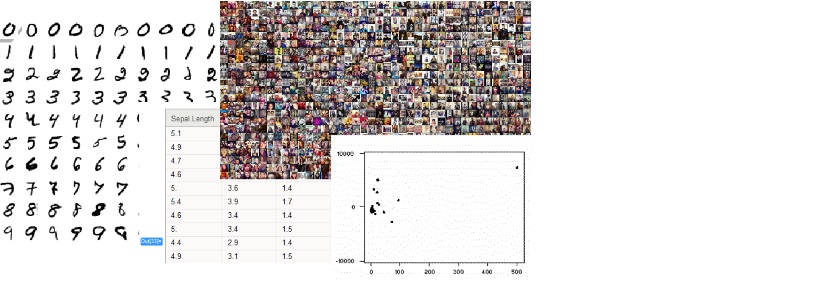

Was sind denn Daten in diesem Sinne? Daten sind eine Reihe von Metriken, die Eigenschaften eines zusammen gruppierten Objekts beschreiben. Alles sind Daten, wenn man genau hinsieht:

Und welche Methoden gibt es? Überraschenderweise gibt es bereits seit einigen Jahrhunderten einige Methoden. Die grundlegenden mathematischen Methoden zur Lösung solcher Probleme beim maschinellen Lernen wie Data Clustering, Klassifikation und Regression wurden bereits im 19. und 20. Jahrhundert von Wissenschaftlern beschrieben. Ein gutes Beispiel ist eine lineare Regression mit kleinsten Quadraten, die 1809 von Gauß eingeführt wurde. Valide und ausreichende Daten fehlten lange Zeit, um entsprechende Lernerfahrungen zu machen. Dank der Entwicklungen des Internets der Dinge und der höheren Verfügbarkeit moderner und leistungsfähiger IT-Infrastrukturen erhalten wir jetzt die Möglichkeit, immer mehr Daten über Fertigungsprozesse zu sammeln.

Was bedeutet das und wo geht die Reise hin?

Wie bereits zu Beginn dieses Artikels erwähnt, kommt das neue Paradigma der Industrie 4.0 in kleineren Schritten. Bevor wir zum Beispiel die „Autonome Fabrik“ erreichen, muss die Transparenz der technologischen Prozesse hergestellt werden. Das bedeutet wiederum, dass die qualifizierten Daten während der Ausführung der Herstellungsprozesse überwacht und gesammelt werden müssen. Als einer der nächsten Schritte könnten wir uns vorstellen, dass diese Daten immer größer, genauer und repräsentativer werden. Das macht maschinelles Lernen möglich und effizient. Dies wiederum ermöglicht die Lösung von wichtigen Geschäftsproblemen wie: Vorbeugende Wartung der Fabrikaanlagen, Steigerung der Gesamtanlageneffektivität auf ein neues Niveau und Optimierung der Lieferketten und anderer umliegender Prozesse.

Nun, und was ist mit Technologien?

Die Industriestandards unterscheiden sich natürlich von denen auf den Verbrauchermärkten, aber die Grundsätze bleiben dieselben. Daher sehen wir es als großen Vorteil an, bereits funktionierende Systeme auf dem Markt des Internets der Dinge wie Smart Houses und prädiktive Systeme beispielsweise in den Bereichen Gesundheit, Versicherung und E-Commerce zu haben. Die Technologien könnten -und werden auch- in der industriellen Automatisierung wiederverwendet werden. Die Ähnlichkeit besteht in allen Ebenen, angefangen von denselben IoT-Geräten, die mit verschiedenen Sensoren verbunden sind, wie Gerätetemperatur, Schall und Vibration, die operative Telemetriedaten an den Edge-Computer innerhalb der Fabrik oder direkt an die Cloud über MQTT oder andere geeignete Protokolle senden müssen . Für die gesammelten Datenanalyseaufgaben können moderne und sich schnell entwickelnde Werkzeuge wie Python und R auf die gleiche Weise verwendet werden, wie sie heute in anderen Enduseranwendungen verwendet werden. Der schnelle Zugriff auf die Big Data und deren Visualisierung kann mit vielen modernen Tools wie „Elasticsearch“ und „Kibana“ gelöst werden. Die Datenmenge wächst heute überall schnell und die entsprechenden Technologien entwickeln sich noch schneller. Wir müssen nur die am besten geeigneten auswählen und diese mit bewährten Erfahrungen auf dem Gebiet der Industrie 4.0 zusammenbringen.